Siguiente: Regresión No Lineal Subir: Mínimos Cuadrados Anterior: Mínimos Cuadrados Índice General

El principio de mínimos cuadrados establece un criterio matemático a través del cual, es posible encontrar la "mejor" línea para un conjunto de parejas de datos. La ventaja de usar un criterio matemático sobre otros métodos visuales (a ojo) es que, en estos últimos, dependemos del juicio personal del experimentador. Por mucho esmero y cuidado que se tenga, los métodos de ajuste visuales no nos dan la seguridad de la importancia cuantitativa de los datos.

A continuación haremos una explicación que nos permita entender el criterio matemático que

establece el método de mínimos cuadrados para encontrar la ''mejor" recta que describa el

comportamiento lineal (si es el caso) de un conjunto de parejas de datos. Supongamos que hemos

registrado ![]() valores de una variable

valores de una variable ![]() medidos como una función de otra variable

medidos como una función de otra variable ![]() . El método

de mínimos cuadrados supone que la incertidumbre asociada a la variable

. El método

de mínimos cuadrados supone que la incertidumbre asociada a la variable ![]() es mucho más pequeña

que la incertidumbre asociada a la variable

es mucho más pequeña

que la incertidumbre asociada a la variable ![]() . En otras palabras, que los valores de

. En otras palabras, que los valores de ![]() se conocen con

una precisión mucho mayor que los de la variable

se conocen con

una precisión mucho mayor que los de la variable ![]() .

.

La pregunta por contestar es: ¿cuál de todas las líneas en el plano ![]() escogemos como la mejor,

y que queremos decir con ''la mejor"?

escogemos como la mejor,

y que queremos decir con ''la mejor"?

Para lo anterior mostramos en la figura ![]() los puntos que representan a nuestras

los puntos que representan a nuestras ![]() parejas de

datos en el plano

parejas de

datos en el plano ![]() . En esta gráfica se muestra la línea

. En esta gráfica se muestra la línea ![]() como la candidata a la ''mejor" línea.

Consideremos todos los intervalos verticales entre cada punto ''experimental" y la línea. Estos intervalos

estan indicados por los segmentos

como la candidata a la ''mejor" línea.

Consideremos todos los intervalos verticales entre cada punto ''experimental" y la línea. Estos intervalos

estan indicados por los segmentos ![]() ,

, ![]() ,

, ![]() , etc.

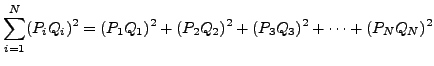

Se define la ''mejor" línea como aquella que minimiza la suma de los

cuadrados de las longitudes de todos estos segmentos, es decir

, etc.

Se define la ''mejor" línea como aquella que minimiza la suma de los

cuadrados de las longitudes de todos estos segmentos, es decir

|

(A.1) |

Encontrar la ''mejor" recta que satisfaga este criterio de minimizar la cantidad

anterior, significa encontrar el valor numérico de pendiente ![]() y ordenada al

origen

y ordenada al

origen ![]() de la misma.

de la misma.

Si suponemos que la ecuación de la mejor recta que representa el comportamiento

lineal de las ![]() parejas de datos mencionadas es:

parejas de datos mencionadas es:

Así el tamaño del segmento

![]() se obtienen en general sustituyendo

se obtienen en general sustituyendo ![]() en términos de la ecuación anterior,

en términos de la ecuación anterior,

El criterio de mínimos cuadrados nos permite obtener los valores deseados de ![]() y

y ![]() a partir

de minimizar la cantidad

a partir

de minimizar la cantidad ![]() , así

, así

Si desarrollamos algebraicamente la suma de binomios que forman la cantidad ![]() de la ecuación dada por (A.11) tenemos que

de la ecuación dada por (A.11) tenemos que

Resolviendo este sistema de ecuaciones para ![]() y

y ![]() respectivamente se obtienen las fórmulas básicas de ajuste de pendiente

respectivamente se obtienen las fórmulas básicas de ajuste de pendiente ![]() y ordenada al origen

y ordenada al origen ![]() de la ''mejor" recta que describe el comportamiento lineal de las

de la ''mejor" recta que describe el comportamiento lineal de las ![]() parejas de datos,

parejas de datos,

Por completez, damos a continuación (sin hacer la deducción) las fórmulas

de las incertidumbres, que el método

de mínimos cuadrados, asocia tanto a la pendiente ![]() , como a la ordenada al origen

, como a la ordenada al origen ![]() ,

,

Por cuestiones prácticas se recomienda construír la siguiente tabla con el fin de hacer claros los cálculos y en su caso poder reproducirlos facilmente y verificar los resultados.

|

|

|